Proyecto Fluently: monitorización en tiempo real de bioseñales para la colaboración humano‑robot

Resumen

El proyecto Fluently representa un cambio de paradigma en la colaboración humano-robot dentro de entornos industriales, con el objetivo de optimizar la productividad al mismo tiempo que se protege el bienestar de los trabajadores. Al integrar neurotecnología avanzada con sistemas de toma de decisiones impulsados por inteligencia artificial, Fluently permite que los robots industriales se adapten en tiempo real al estado cognitivo y físico del operario.

Mediante una novedosa interfaz humano-máquina, los operadores pueden controlar a los robots utilizando el habla natural y gestos, mientras que su condición mental y fisiológica se evalúa a través de tecnologías wearable, como el Bitbrain Versatile Bio Amplifier para la monitorización de bioseñales y el dispositivo Bitbrain Diadem EEG de 12 canales para el registro de señales EEG.

Las contribuciones de la Universidad de Ciencias Aplicadas y Artes del Sur de Suiza (SUPSI) incluyen el desarrollo de un pipeline multimodal que preserva la privacidad, capaz de inferir en tiempo real el estado mental del usuario y de adaptar el comportamiento del robot mediante marcos de aprendizaje colaborativo.

Esta publicación explora los objetivos del proyecto, su infraestructura tecnológica y sus aplicaciones en el mundo real, y destaca cómo Fluently establece nuevos estándares para una automatización ética, eficiente y enfocada en el ser humano.

Introducción

Portada de la revista Robotics protagonizada por el paper de MultiPhysio-HRC

Portada de la revista Robotics protagonizada por el paper de MultiPhysio-HRC

El proyecto Fluently tiene como objetivo llevar la interacción humano‑robot en entornos industriales un paso más allá. Su finalidad es aprovechar los últimos avances en la toma de decisiones basada en inteligencia artificial para alcanzar una colaboración social real entre personas y máquinas en contextos de fabricación altamente dinámicos. Uno de los aspectos clave de esta colaboración social es la capacidad de comprender al otro.

El estado de la colaboración tiene un impacto significativo en las acciones que pueden llevarse a cabo o ejecutarse. El contenido de la interacción humano‑robot, el tono del habla, los gestos, las expresiones faciales y la carga física o cognitiva son factores que pueden utilizarse para determinar el estado general del operario y, posteriormente, ajustar la carga de trabajo o el ritmo de la interacción en consecuencia.

El EEG y otras bioseñales, como el ECG o las métricas basadas en el uso de oxímetros de pulso, son elementos clave para determinar el estado del ser humano. A diferencia de los sistemas de reconocimiento y análisis facial o del habla, las bioseñales no pueden modificarse de forma consciente por la persona. Por ejemplo, una persona puede mentir, hablar de manera irónica o forzar una expresión facial para ocultar su estado real. Las bioseñales, en cambio, constituyen medidas objetivas que codifican variables como la carga física o el esfuerzo cognitivo que se ejercen durante la ejecución de una tarea.

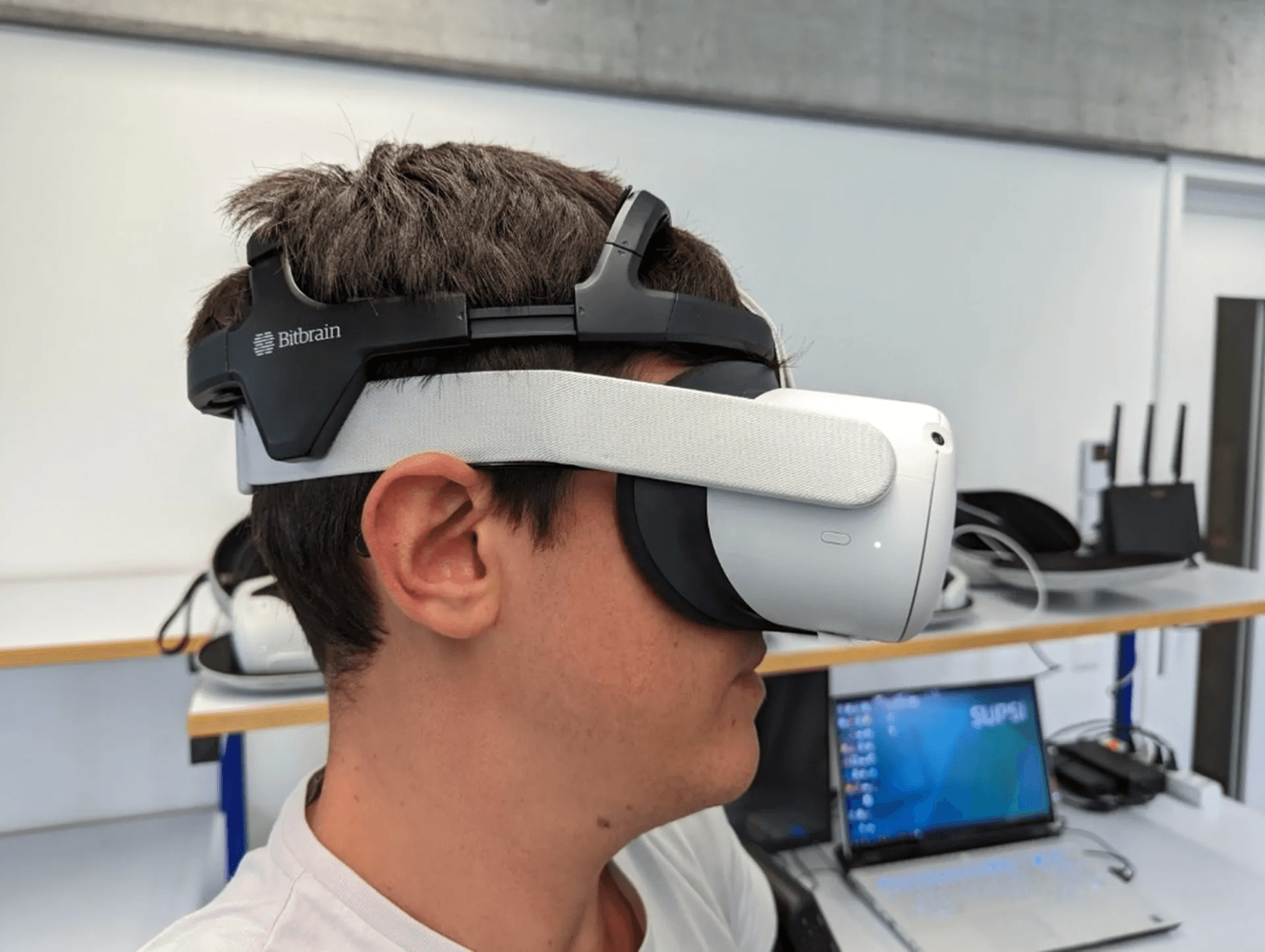

Escenario de Realidad Virtual con el casco Bitbrain Diadem EEG

Escenario de Realidad Virtual con el casco Bitbrain Diadem EEG

Explorando el proyecto Fluently

Objetivos y desafíos

En la industria manufacturera moderna, los robots aportan a las tareas de producción mayor precisión, fuerza y resistencia que los seres humanos. Al mismo tiempo, las personas aportan experiencia, capacidad de juicio y previsión. El objetivo de la interacción humano‑robot en la industria inteligente es integrar y potenciar simultáneamente las capacidades complementarias de humanos y robots mientras trabajan juntos para alcanzar un objetivo común. El proyecto europeo Fluently, tiene como finalidad mejorar el estado actual de la interacción humano‑robot en sectores industriales como el manufacturero. Para ello, el equipo Fluently está desarrollando una interfaz humano‑máquina que permite a los robots interpretar mejor las necesidades de su compañero humano. El marco Fluently aprovecha los últimos avances en los procesos de toma de decisiones basados en inteligencia artificial, con el objetivo de lograr una colaboración social auténtica entre personas y máquinas, adaptándose al mismo tiempo a contextos de fabricación extremadamente dinámicos.

En este contexto, los dos autores de este blog han participado, junto con otros autores, en la publicación del artículo “MultiPhysio-HRC: A Multimodal Physiological Signals Dataset for Industrial Human–Robot Collaboration”. El objetivo de este trabajo es proporcionar un dataset multimodal diseñado para investigar los estados psicofisiológicos humanos, como el estrés y la carga cognitiva, en escenarios realistas de colaboración humano‑robot (HRC) dentro del marco de la Industria 5.0 [5].

Características del marco:

- Interpretación del contenido del habla, el tono de voz y los gestos, que se traducen automáticamente en instrucciones para el robot, haciendo que los robots industriales sean accesibles a cualquier perfil de habilidades.

- Evaluación del estado del operario mediante una infraestructura específica de sensores, destinada a enriquecer un marco de comportamiento basado en IA que permite a los robots adaptar sus estrategias de asistencia en función de la condición del operario.

- Modelado de productos y cambios en la producción de forma que puedan ser reconocidos, interpretados y asociados por los robots en cooperación con los humanos. De este modo, Fluently garantiza que la colaboración potencie las capacidades del operario sin sobrecargarlo.

Fluently introduce dos elementos clave:

- La Interfaz Inteligente (Smart Interface): permite a los operarios dar instrucciones a los robots de forma intuitiva mediante el uso del habla y los gestos, adaptando el comportamiento del robot en tiempo real a las condiciones del operario y optimizando el rendimiento.

- El Robo‑Gym: una instalación de entrenamiento y pruebas en la que humanos y robots aprenden a colaborar. Este entorno facilita que ambos se adapten de forma fluida entre sí, mejorando la cooperación y la eficiencia.

Los retos que aborda el proyecto Fluently son:

- Introducir la robótica en cadenas de valor altamente dependientes de actividades humanas, formando a personas sin conocimientos previos de automatización para que puedan colaborar de manera fluida con robots.

- Avanzar hacia cero desperdicios y cero inactividad en la producción, reduciendo la carga física y cognitiva del operario gracias a comportamientos robóticos adaptados específicamente al ser humano con el que trabajan.

- Reducir el tiempo de puesta en marcha ante cambios en la producción, como tipos de piezas, variantes, volúmenes y proporciones de mezcla, mediante el uso de inteligencia artificial para permitir el reconocimiento, la clasificación y la inferencia de nuevas recetas y estrategias de proceso.

Impacto potencial de un proyecto que combina robótica e interacción humana (implicaciones para la salud, la rehabilitación y la industria)

Los trabajadores humanos en la industria manufacturera se enfrentan con frecuencia a situaciones de alto estrés, en las que deben realizar tareas de gran complejidad con recursos limitados. En estos escenarios, el valor de la automatización no reside únicamente en la optimización de la calidad y los recursos, sino también en la preservación del bienestar de los trabajadores. El nivel de carga cognitiva y física fluctúa constantemente en respuesta a las exigencias de la producción.

Los robots equipados con Fluently evaluarán de forma continua la carga física y cognitiva de los operarios, aprenderán de la interacción y adquirirán experiencia junto a sus compañeros humanos, con el fin de establecer prácticas de fabricación que se basen tanto en la calidad como en el bienestar de los operarios. Esta sinergia innovadora está diseñada para aliviar las cargas físicas y cognitivas en los humanos, mejorando al mismo tiempo la eficiencia y la seguridad [1].

Actualmente, ningún robot industrial es capaz de interpretar un contexto de este tipo y deliberar de manera autónoma para optimizar la calidad y la productividad sin dejar de cuidar a los trabajadores humanos. Fluently establece nuevos estándares en la fabricación industrial, en los que la tecnología potencia las capacidades humanas y protege su bienestar, sentando las bases de una nueva era de innovación industrial cooperativa.

En este vídeo de la experiencia de entrenamiento de Fluently, un participante, equipado con el casco Bitbrain Diadem EEG y el Bitbrain Versatile Bio Amplifier, participa en un juego de realidad virtual (Richie’s Plank Experience), en el que debe caminar sobre una tabla suspendida donde debe caminar sobre un edificio. Esta tarea ayuda a provocar niveles elevados de estrés y activación fisiológica.

El rol de SUPSI en el proyecto Fluently

Contribuciones e hitos alcanzados

Para abordar los retos del proyecto Fluently, el equipo de SUPSI diseñó y llevó a cabo una campaña experimental ad hoc. Dicha campaña se estructuró en torno a los casos de uso industriales del proyecto e involucró a varios participantes que realizaron las tareas colaborando directamente con un robot industrial.

Durante la colaboración, se administraron cuestionarios psicológicos y se recogieron múltiples señales fisiológicas con el objetivo de relacionar los estados percibidos de los operarios con sus respuestas fisiológicas. Estos datos se utilizaron para desarrollar modelos de aprendizaje automático que serán implementados en el dispositivo H‑Fluently.

SUPSI aprovechó la amplia variedad de modalidades y sensores empleados para desarrollar un enfoque multimodal [2] capaz de predecir de forma fiable el estado mental del operario.

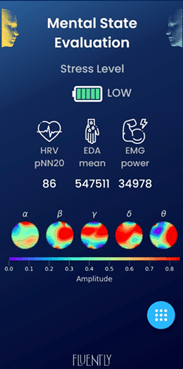

Interfaz de la app Fluently

Con el apoyo de Bitbrain, SUPSI desarrolló un pipeline para la adquisición y el procesamiento de datos fisiológicos procedentes del Versatile Bio y del EEG Diadem, que se ejecuta directamente en el dispositivo H‑Fluently. Este pipeline comprende múltiples etapas, que incluyen el procesamiento y filtrado en línea de señales, la extracción de características y la inferencia de modelos. El modelo realiza la inferencia directamente en el dispositivo móvil y proporciona retroalimentación directa al operario a través de la interfaz de la aplicación Fluently.

El participante, configurado con el equipo Bitbrain Diadem EEG y el Bitbrain Versatile Bio Amplifier, dirige al robot para que ejecute tareas durante la experiencia de entrenamiento del proyecto Fluently.

Este pipeline se integró en un marco de preservación de la privacidad (privacy‑preserving framework) con el fin de proteger los datos sensibles del operario. Dicho marco incorpora aprendizaje federado (Federated Learning, FL), una técnica que permite el entrenamiento colaborativo de modelos en dispositivos descentralizados sin comprometer la privacidad de los datos [3]. Mediante FL, es posible ajustar finamente el modelo de aprendizaje automático directamente en el dispositivo, utilizando datos específicos de cada sujeto, con el objetivo de mejorar su capacidad de inferencia para esa persona en concreto. Al mismo tiempo, el modelo global se mejora de forma continua mediante la agregación de los pesos de los modelos personalizados individuales, sin que en ningún momento se transfieran o reciban datos sensibles.

A partir de la predicción del estado mental del ser humano, desarrollamos comportamientos adaptativos que el robot aprende a través de la colaboración directa y en entorno real con su compañero humano. De este modo, el robot puede aprender las preferencias de cada operario y actuar en consecuencia para reducir su carga psicofísica.

Caso de estudio: Bitbrain Versatile Bio Amplifier y el casco Bitbrain Diadem EEG de 12 canales

Descripción general de los dispositivos: características y especificaciones clave

El Bitbrain Versatile Bio Amplifier y el Diadem EEG son dispositivos portátiles de neurotecnología de grado de investigación, diseñados para la adquisición de datos de alta calidad en condiciones reales. El Versatile Bio Amplifier registra múltiples señales fisiológicas (como ECG, EMG, GSR, respiración, temperatura y movimiento) con sincronización precisa, lo que lo convierte en una herramienta ideal para estudios multimodales del comportamiento humano.

Por su parte, el Diadem EEG es un casco EEG de electrodos secos, ligero y cómodo, que permite capturar la actividad cerebral de forma rápida y cómoda, sin necesidad de geles, facilitando tanto la puesta en marcha como la monitorización fiable de estados cognitivos y emocionales. Combinados, ambos dispositivos proporcionan soluciones móviles, flexibles y multimodales para aplicaciones en neurociencia, factores humanos y neurotecnología aplicada, tanto en entornos de laboratorio como en entornos fuera de laboratorio.

A la izquierda, Bitbrain Diadem EEG de 12 canales. A la derecha, el Bitbrain Versatile Bio Amplifier

A la izquierda, Bitbrain Diadem EEG de 12 canales. A la derecha, el Bitbrain Versatile Bio Amplifier

Integración del Bitbrain Versatile Bio Amplifier y del Diadem EEG en el proyecto Fluently y su contribución a su avance

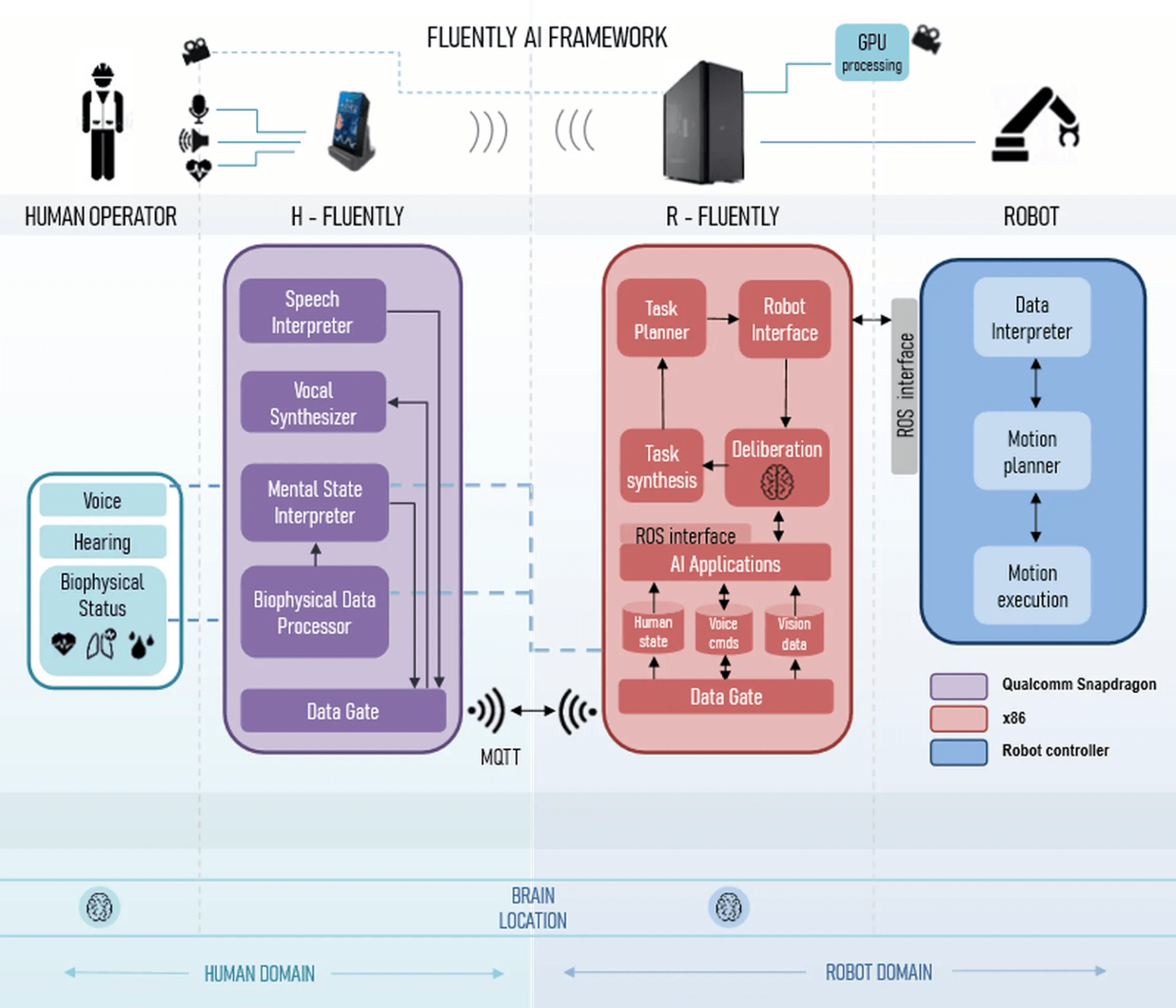

Los componentes del marco de IA de Fluently están distribuidos en múltiples dispositivos. El flujo de información comienza en H‑Fluently, donde se recogen los datos fisiológicos del operario y se procesan directamente en el dispositivo. A continuación, dicha información se transmite a R‑Fluently, donde se despliegan los principales componentes de inteligencia del robot, para finalizar en la comunicación con el controlador del robot, encargado de ejecutar las órdenes de movimiento.

Los dispositivos Versatile Bio y Diadem EEG se integran en el dispositivo H‑Fluently mediante el SDK de Bitbrain. Estos dispositivos permiten la adquisición de datos en tiempo real, lo que constituye el primer paso esencial para evaluar el estado psicofísico del ser humano.

Los dispositivos Bitbrain Versatile Bio Amplifier y Bitbrain Diadem EEG resultaron fáciles de utilizar y funcionaron adecuadamente en un entorno industrial, demostrando que el EEG es una herramienta adecuada para este tipo de escenarios. Su diseño ligero e inalámbrico permite al operario moverse con libertad sin interferir en la realización de sus tareas. La integración con el sistema Fluently mediante el SDK de Bitbrain facilitó la captura y el procesamiento de los datos fisiológicos en tiempo real directamente en el dispositivo H‑Fluently. Los sensores proporcionaron datos precisos y fiables, un elemento clave para la detección del estado mental del operario. En conjunto, los dispositivos resultaron cómodos para los usuarios y prácticos para su uso en un entorno real de fábrica, aportando un valor significativo al progreso del proyecto.

Marco de IA de Fluently

Marco de IA de Fluently

Conclusión

El proyecto Fluently demuestra cómo la integración de la monitorización de bioseñales y el comportamiento inteligente del robot puede transformar la interacción humano‑robot en entornos industriales. Dispositivos como el Bitbrain Versatile Bio Amplifier y el Bitbrain Diadem EEG han resultado esenciales para evaluar con precisión el estado del operario y permitir adaptaciones en tiempo real. Los marcos de procesamiento multimodal y de aprendizaje automático preservador de la privacidad desarrollados por SUPSI permiten un despliegue robusto y ético de estas tecnologías.

A medida que la neurotecnología y la robótica colaborativa continúan evolucionando, Fluently abre el camino hacia futuros sistemas industriales en los que los robots dejan de ser simples herramientas para convertirse en socios empáticos, capaces de mejorar tanto el bienestar humano como la eficiencia operativa.

Sobre los autores

Andrea Bussolan es un estudiante de doctorado en el laboratorio de Automatización, Robótica y Máquinas (ARM) del Departamento de Tecnologías Innovadoras de SUPSI, donde se centra en la colaboración humano‑robot, la evaluación de la carga cognitiva y fisiológica, y la adquisición multimodal de datos en entornos reales. Su trabajo combina robótica, ergonomía y neurociencia, utilizando EEG y bioseñales para estudiar cómo el estrés y la carga cognitiva afectan a los operarios durante tareas industriales colaborativas entre humanos y robots. Asimismo, investiga técnicas de IA preservadoras de la privacidad, como el aprendizaje federado, para desarrollar modelos personalizados que permitan una interacción humano‑robot más segura y adaptativa. Perfil de ResearchGate, Google Scholar, LinkedIn.

Pablo Urcola Irache es investigador con un doctorado en Ingeniería de Sistemas e Informática, especializado en robótica. Con más de quince años de experiencia en proyectos de I+D nacionales e internacionales, ha centrado su labor en el desarrollo de tecnologías con impacto real. Como ingeniero de software, aplica su experiencia en sistemas y robótica para avanzar en el ámbito de la neurorehabilitación con el desarrollo de prototipos robóticos controlados por el pensamiento que responden a la actividad cerebral, contribuyendo a acercar la neurotecnología a los usuarios finales. Su trabajo facilita su despliegue en el hogar y en entornos reales, promoviendo soluciones accesibles y aplicadas. ResearchGate, Google Scholar, LinkedIn.

Referencias

[1] A. Valente, G. Pavesi, M. Zamboni, e E. Carpanzano, «Deliberative robotics – a novel interactive control framework enhancing human-robot collaboration», CIRP Annals, vol. 71, fasc. 1, pp. 21–24, 2022, doi: 10.1016/j.cirp.2022.03.045.

[2] A. Bussolan, S. Baraldo, L. M. Gambardella, e A. Valente, «Multimodal fusion stress detector for enhanced human-robot collaboration in industrial assembly tasks», in 2024 33rd IEEE International Conference on Robot and Human Interactive Communication (ROMAN), ago. 2024, pp. 978–984. doi: 10.1109/RO-MAN60168.2024.10731373.

[3] P. Kairouz et al., «Advances and Open Problems in Federated Learning», 8 marzo 2021, arXiv: arXiv:1912.04977. Consultato: 11 novembre 2022. [Online]. Disponibile su: http://arxiv.org/abs/1912.04977

[4] Avram O., Human expertise and robotic precision: how the University of Applied Sciences and Arts of Southern Switzerland uses Qualcomm AI Hub, https://www.qualcomm.com/developer/blog/2024/11/university-applied-sciences-arts-southern-switzerland-qualcomm-ai-hub

[5] Bussolan, A., Baraldo, S., Avram, O., Urcola, P., Montesano, L., Gambardella, L. M., & Valente, A. (2025). MultiPhysio-HRC: A Multimodal Physiological Signals Dataset for Industrial Human–Robot Collaboration. Robotics, 14(12), 184. https://doi.org/10.3390/robotics14120184